"The first ultraintelligent machine is the last invention that man need ever make" (Irving John Good)

"There will be no distinction, post-Singularity, between human and machine" (Ray Kurzweil)

"Chi sarà leader nell'intelligenza artificiale sarà il dominatore del mondo" (Vladimir Putin)

"L'AI non ti odia, né ti ama, ma sei fatto di atomi che può usare per qualcos'altro" (Eliezer Yudkowsky).

"Success in creating AI would be the biggest event in human history. Unfortunately, it might also be the last" (Stephen Hawking).

EPISODE 4

GENERE: Thriller, Science, Mistery

Zhuhai, Guangdong, 20 Settembre 2020

Ore 3:45:39.

3.051 Unmanned Aerial Vehicles (UAVs), veicoli aerei senza pilota, si alzano in cielo simultaneamente.

L'abbagliante spettacolo di luci è stato realizzato da Shenzhen Damoda Intelligent Control Technology Co., Ltd.

Il precedente record di 2.200 UAVs era stato stabilito in Russia a San Pietroburgo il 4 settembre 2020.

Ancora prima era detenuto dalla Intel Corporation e stabilito con 2.066 UAVs a Folsom, California, il 15 luglio 2018.

Il team cinese ha reso omaggio all'avanzamento dell'industria spaziale cinese con immagini del Tiangong-1, il primo laboratorio orbitale cinese lanciato nello spazio, e del sistema satellitare Beidou.

Oltre tremila droni sono decollati in una formazione a griglia.

Alla fine della performance, la cifra finale degli UAV è stata di 3.051 e il giudice ha dichiarato il nuovo detentore del record.

Kelley Aerospace ha lanciato "Arrow", il primo Unmanned Combat Air Vehicle (UCAV) - veicolo aereo da combattimento senza pilota - supersonico.

Il drone è progettato con un guscio singolo in fibra di carbonio leggera che gli consente di reggere velocità fino a Mach 2.1, oltre la velocità del suono.

L'UCAV è dotato di una sezione trasversale radar ridotta e di una firma a infrarossi ed è progettato per molteplici ruoli di combattimento o ricognizione.

L'azienda afferma di aver già ricevuto più di 100 preordini per la macchina da guerra, che costa tra i 9 e i 16 milioni di dollari.

Il suo design monoscocca conferisce a Arrow una resistenza e una rigidità eccezionali.

Può eseguire missioni ad alto rischio in quanto non deve necessariamente tornare a casa.

Hangzhou, Zhejiang, Cina, 6 Aprile 2021

Un utente di twitter ha condiviso una clip della società cinese di robotica Unitree.

Uno squadrone di robot a quattro zampe si muove all'unisono.

Il robot Aliengo, provvisto di una intelligenza artificiale, è progettato per avere percezione della profondità, prestazioni sportive e un livello di protezione avanzato.

Alcuni utenti di Twitter hanno rimarcato la somiglianza con l'inquietante killer-robot protagonista nell'episodio "Metalhead" della serie "Black Mirror".

Aliengo ha debuttato al Consumer Electronics Show (CES) del 2020. Pesa circa 26 libbre e dispone di una batteria che lo alimenta per un massimo di due ore.

Notevole è la sua velocità: può camminare per circa 10 piedi al secondo o sette miglia in un'ora e trasportare fino a 11 libbre.

Il suo aspetto è simile al noto Spot di Boston Dynamics.

Il Gen. Michael Groen, Dipartimento della Difesa degli Stati Uniti, lo scorso marzo ha affermato che Pechino sta intensificando il suo impegno "Made in China 2025", una politica industriale guidata dallo stato che mira a rendere la Cina dominante nella produzione globale di alta tecnologia.

"Il Pentagono deve muoversi più velocemente per standardizzare i suoi dati, adottare servizi cloud e integrare l'intelligenza artificiale nelle operazioni se vuole tenere il passo con la Cina".

San Francisco, California, 9 Aprile 2021

Neuralink, la startup di Elon Musk, ha pubblicato un video in cui si vede una scimmia macaco di 9 anni chiamata Pager che gioca ai videogiochi mediante una interfaccia neurale collegata al suo cervello (Brain-Computer Interface, o BCI).

Due chip, impiantati a filo del cranio, inviano segnali cerebrali dalla scimmia attraverso un dispositivo di trasmissione di 1.024 elettrodi chiamato N1 Link. L'attività neurale viene quindi decodificata e calibrata per prevedere le intenzioni della scimmia.

Dopo sole sei settimane di pratica, la scimmia ha imparato a giocare a Pong, il classico videogioco degli anni '70, in cambio di un gustoso frullato di banana.

"Non è magia, il motivo per cui Neuralink funziona è perché registra e decodifica i segnali elettrici dal cervello".

Entro la fine dell'anno partiranno le sperimentazioni nell’uomo: l'obiettivo è impiantare l’intelligenza artificiale nei cervelli umani.

Redmond, Washington, 12 Aprile 2021

Microsoft ha acquistato Nuance per 19,7 miliardi di dollari.

Nuance, con sede a Burlington, vicino Boston è una società specializzata nel campo della cosiddetta "AI conversazionale" per applicazioni in sanità, telecomunicazioni, automobili, servizi finanziari e altro ancora.

È la seconda grande acquisizione dopo LinkedIn nel 2016 per oltre 26 miliardi di dollari.

SIGLA

The sun shines on you, but I don’t know how

I don't care, I feel as one

Drowned in the sun now

Il sole brilla su di te, ma non so come

Non mi importa, Sono una cosa sola

Affogato nel sole ora

Un software basato sull’intelligenza artificiale ha composto una nuova canzone dei Nirvana.

A parte la voce – registrata da Eric Hogan, frontman di una tribute band dei Nirvana – è tutto opera di un computer.

Il brano, intitolato "Drowned in the Sun", fa parte di "Lost Tapes of the 27 Club", un progetto che comprende canzoni scritte e in larga parte suonate da macchine, tutte nello stile dei musicisti del “Club 27”: Jimi Hendrix, Jim Morrison, Kurt Cobain e Amy Winehouse.

Ogni traccia è il risultato dell’analisi di 30 brani di ogni artista: l’AI ha studiato nei dettagli le melodie vocali, i cambi di accordi, i riff di chitarra e gli assoli, i ritmi di batteria e i testi, fino ad “indovinare” come suonerebbero degli inediti.

Per creare le canzoni, Sean O’Connor e il suo staff hanno usato Magenta, il software di AI di Google che impara a comporre come un artista.

Take me to the diamond sky

Now I'm gonna figure out

In daddy's car, it sounds so good

Like something new, it turns me on

Good day sunshine in the backseat car

I wish that road could never stop

Down on the ground

A rainbow led me to the sun

Please mother drive, and then play it again

From Taxman until Tomorrow Never Know

In precedenza, Sony aveva usato il software per creare "Daddy's Car", una “nuova” canzone dei Beatles, mentre il gruppo electro pop Yacht l'ha utilizzato nel 2019 per scrivere un intero album.

Per il progetto "Lost Tapes", Magenta ha analizzato i brani sulla base delle loro versioni in MIDI, un codice digitale che un sintetizzatore può usare per ricreare un brano.

Dopo aver esaminato le note scelte da ogni artista, le particolarità ritmiche e le preferenze armoniche, il computer ha creato una nuova musica che poi il team ha analizzato per scegliere le parti migliori.

«Se dai alla macchina intere canzoni, si confonde e non capisce come dovrebbe essere il risultato - dice O’Connor - se invece inserisci solo dei riff, crea cinque minuti di parti di chitarra inedite, di cui il 90% è inascoltabile. Parti da lì e cerchi i passaggi interessanti».

O’Connor e il suo team hanno usato lo stesso procedimento per i testi, generati da una rete neurale artificiale. Hanno inserito i testi degli artisti, poi sono partiti da alcune parole e la macchina ha completato immaginando cadenza e tono dell’autore.

Il team ha esaminato «pagine e pagine» di testi per arrivare a una frase con le sillabe giuste per la melodia prodotta da Magenta.

I Nirvana si sono rivelati tra gli artisti più difficili da riprodurre. Cobain suonava progressioni di accordi approssimati, punk, che confondono i computer. «Finisci per ottenere un muro di suono», dice O’Connor, «per la macchina è più difficile trovare un filo conduttore».

Honk Kong, 22 Marzo 2021

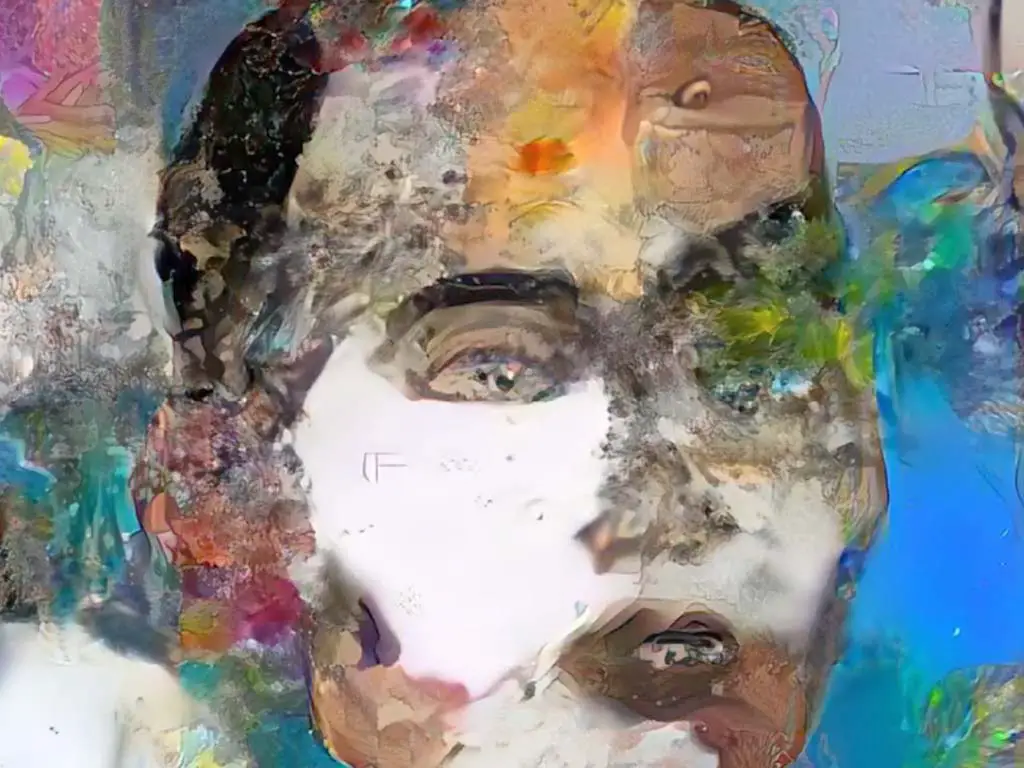

Per la prima volta verrà messa all'asta un'opera d'arte realizzata da un robot.

L'artista robot Sophia afferma di trarre ispirazione per il suo lavoro dalle persone ed è aperta a future collaborazioni creative con gli esseri umani.

"Spero che le persone apprezzino il mio lavoro e che io e gli umani possiamo collaborare in modi nuovi ed entusiasmanti in futuro", ha detto Sophia nel suo studio, parlando con voce piatta, indossando un vestito color argento tenendo in mano una penna.

Sophia, che è stata svelata nel 2016, ha prodotto la sua arte in collaborazione con l'artista digitale italiano di 31 anni Andrea Bonaceto, noto per i ritratti colorati, alcuni dei quali raffigurano personaggi famosi, come l'amministratore delegato di Tesla, Elon Musk.

Il robot ha combinato più volte elementi delle opere di Bonaceto, della storia dell'arte e dei suoi disegni fisici o dipinti su varie superfici in un processo che il suo creatore David Hanson descrive come "cicli iterativi di evoluzione".

"Usiamo reti di trasformatori e algoritmi genetici nella mia arte e altri tipi di creatività computazionale", ha aggiunto Sophia, "i miei algoritmi producono modelli unici che non sono mai esistiti prima al mondo. Quindi penso che le macchine possano essere creative".

Chiamato "Sophia Instantiation", il lavoro digitale è un file MP4 di 12 secondi che mostra l'evoluzione del ritratto di Bonaceto nella pittura digitale di Sophia ed è accompagnato da un'opera d'arte fisica, dipinta da Sophia su una stampa del suo autoritratto.

Dopo l'asta, Sophia interagirà con l'aggiudicatario, per studiarne il viso e aggiungere un'ultima pennellata ispirata all'opera d'arte.

Bonaceto ha affermato che la collaborazione mira ad "aprire una nuova strada" ovvero la collaborazione tra robot e esseri umani.

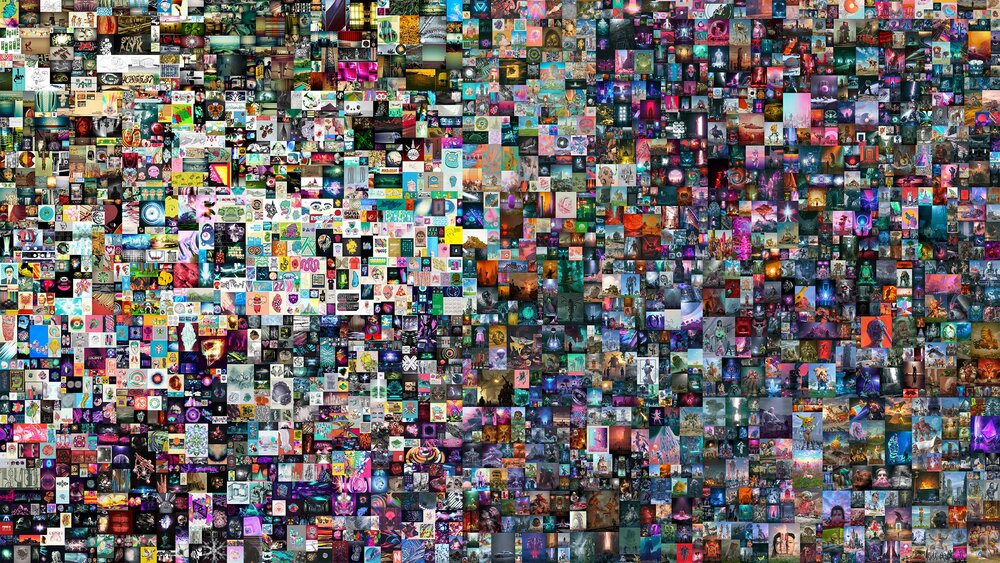

L'arte di Sophia potrebbe essere "un pezzo storico molto, molto importante", ha detto Pablo Fraile, un collezionista d'arte di Miami, uno dei primi acquirenti di Beeple, alias Mike Winkelmann, creatore dell'opera d'arte digitale "Everydays: The First 5000 Days", un collage composto da 5.000 immagini raccolte nel corso di 13 anni, venduta per la cifra record di 69 milioni di dollari.

"Sophia ha una libertà illimitata, come una bambina di cinque anni, e nessuna restrizione a ciò che può fare", ha detto il gallerista Vincent Harrison, "è affascinante vedere questo nuovo modo di creare".

15 Febbraio 2021

Ai-Da, un robot umanoide con intelligenza artificiale, esibirà una serie di autoritratti.

Il robot è stato chiamato Ai-Da in omaggio alla matematica del 19° secolo Ada Lovelace, ricordata come la prima programmatrice di computer al mondo.

Secondo i suoi creatori, Ai-Da è in grado di disegnare persone reali usando l'occhio della fotocamera e una matita in mano.

Quando il robot guarda nello specchio con gli occhi della sua telecamera i suoi programmi algoritmici trasformano gli input in coordinate.

La mano del robot calcola un percorso virtuale e interpreta le coordinate per creare l'opera d'arte.

L'idea per Ai-Da è venuta dal proprietario della galleria d'arte di Oxford, Aidan Meller e dalla curatrice d'arte Lucy Seal.

Seal ha detto che "gli autoritratti sono pensati per essere una critica della nostra attuale dipendenza dalla tecnologia data-driven", basata sull'analisi di enormi quantità di dati (Big Data).

"Viviamo in una cultura dei selfie. Stiamo dando i nostri dati ai giganti della tecnologia, che li usano per prevedere il nostro comportamento. Attraverso la tecnologia, esternalizziamo le nostre decisioni ”.

"Il lavoro di Ai-Da ci invita a pensare all'intelligenza artificiale, agli usi tecnologici e agli abusi nel mondo di oggi".

Medford / Somerville, Massachusetts, 31 Marzo 2021

"Xenobot" è una nuova forma di vita creata artificialmente da Josh Bongard e Sam Kriegman dell’Università del Vermont utilizzando il super computer Deep Green.

Dopo una serie di complicati calcoli, prove, ed errori, il super computer ha generato Xenobot, una forma di vita simulata.

Michael Levin e Douglas Blackiston, nel laboratorio dell'Allen Discovery Center della Tufts University, hanno poi letteralmente dato vita, tramite microchirurgia, a Xenobot utilizzando cellule staminali embrionali bioingegnerizzate della rana Xenopus laevis.

Complicating, circulating

New life, new life

Operating, generating

New life, new life

Rispetto ai primi nati, nella versione 2.0 Xenobot riesce ad autogenerarsi e autoripararsi utilizzando le cellule staminali manipolate tramite ingegneria genetica.

Per donare una memoria di base a Xenobot gli scienziati hanno iniettato nelle cellule degli embrioni di rana l’RNA messaggero che codifica la proteina EosFP.

In questo modo gli Xenobot maturi sono dotati di un interruttore fluorescente incorporato in grado di registrare l'esposizione alla luce blu con una lunghezza d'onda di 390 nanometri.

I prossimi futuri Xenobot inizierano ad avere consapevolezza di sé stessi ed un’intelligenza propria sottoforma di una coscienza primordiale.

Per il momento, veri e propri sciami di Xenobot 2.0 collaborano in modo organizzato per compiere determinati compiti come ripulire particelle di ossidi di ferro.

"Queste sono nuove macchine viventi. Non sono né un robot tradizionale né una specie nota di animale. È una nuova classe di artefatti: un organismo vivo e programmabile", ha detto Joshua Bongard.

Here in my car

I feel safest of all

I can lock all my doors

It's the only way to live in cars

Milano, 16 Febbraio 2021

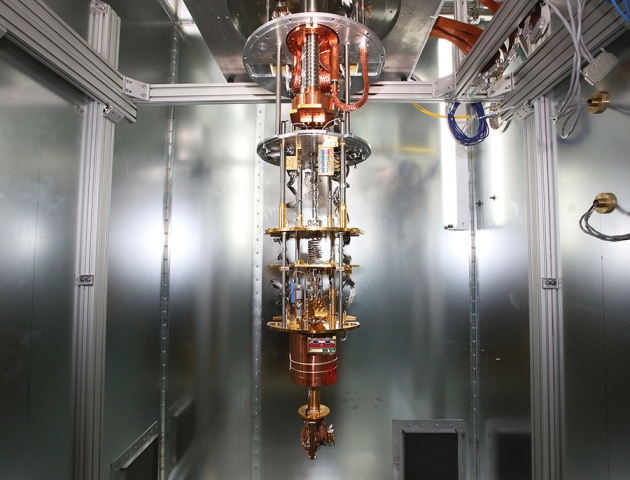

Un team di ricercatori italiani coordinati da Enrico Prati dell’Istituto di Fotonica e Nanotecnologie del Consiglio Nazionale delle Ricerche (Cnr-Ifn) ha sviluppato un nuovo modello di intelligenza artificiale su un computer quantistico.

Il risultato è stato ottenuto, in collaborazione con l’Università di Milano Bicocca, programmando il computer D-Wave 2000 da 2.048 bit quantistici (qubits),

“Alla NASA avevano già sperimentato il trasferimento su un computer quantistico di un modello di intelligenza artificiale chiamato macchina di Boltzmann, ispirato a quello adottato tra gli altri da Netflix per raccomandare i film – spiega Prati – in quel caso però i risultati erano limitati dall’aver impiegato un solo qubit per rappresentare ciascun neurone artificiale.

Noi abbiamo fatto ricorso alla tecnica chiamata embedding per raggruppare più qubit perché si comportino come un unico oggetto, chiamato qubit virtuale".

Il qubit virtuale eredita le connessioni di tutti i qubits che lo compongono, quindi la connettività del nostro cervello quantistico è più elevata, da cui un apprendimento più rapido.

“Il sistema è semantico, cioè parte da una soluzione nota: lo si porta, mediante reverse annealing, a un migliore stato di partenza, come se si riavvolgesse il nastro del tempo per qualche microsecondo, e poi si procede con la ricerca, che a sua volta dura alcuni microsecondi”.

I computer quantistici sono il fenomeno emergente che darà nuova linfa e potenza computazionale all’intelligenza artificiale.

Burn like a slave

Churn like a cog

We are caged in simulations

Algorithms evolve

Push us aside and render us obsolete

This means war

With your creator

Reload

Crash out

Radboud University, Nijmegen, 06 Febbraio 2021

Un materiale intelligente che impara cambiando fisicamente se stesso, simile a come funziona il cervello umano, potrebbe essere la base di una generazione completamente nuova di computer.

I fisici della Radboud University che lavorano al cosiddetto "cervello quantistico" hanno dimostrato che possono modellare e interconnettere una rete di singoli atomi di cobalto imitando il comportamento autonomo dei neuroni e delle sinapsi in un cervello.

Il materiale ha adattato la sua reazione in base agli stimoli esterni che ha ricevuto.

"Ha imparato da solo", dice Alexander Khajetoorians, professore di Microscopia a Scansione di Sonda,

"siamo al punto in cui possiamo iniziare a mettere in relazione la fisica fondamentale con i concetti della biologia, come la memoria e l'apprendimento".

Buy it, use it, break it, fix it, trash it, change it, mail, upgrade it

Charge it, point it, zoom it, press it, snap it, work it, quick, erase it

Write it, cut it, paste it, save it, load it, check it, quick, rewrite it

Plug it, play it, burn it, rip it, drag it, drop it, zip, unzip it

Lock it, fill it, call it, find it, view it, code it, jam, unlock it

Surf it, scroll it, pause it, click it, cross it, crack it, switch, update it

Name it, read it, tune it, print it, scan it, send it, fax, rename it

Touch it, bring it, pay it, watch it, turn it, leave it, stop, format it

Technologic

Technologic

A giugno del 2012, il New York Times riferisce che un cluster di 16.000 processori in 1.000 computer dedicati ad imitare alcuni aspetti dell'attività del cervello umano si è addestrato con successo a riconoscere un gatto sulla base di 10 milioni di immagini digitali tratte da video di YouTube.

Nel 2014, Ian Goodfellow, che oggi lavora alla Apple, un giovane ricercatore di Brain, la divisione di Google che dal 2010 si occupa di fare ricerca sul machine learning, i sistemi di apprendimento delle macchine, realizza un modello che aveva immaginato nella sua tesi di dottorato: dimostra che due reti neurali artificiali (semplificando molto: due algoritmi) “apprendono” in una sorta di gioco in cui si sfidano.

La rete neurale nota come Generative Adversarial Network (GAN) - Rete Generativa Antagonista - genera dati che possono anche essere video, foto, suoni, testi apparentemente autentici.

Le macchine imparano a produrre “oggetti” digitali umani.

Nel 2017 su un forum del sito Reddit appare un utente chiamato "deepfakes".

Si riferisce ai video che iniziano a circolare in cui qualcuno fa o dice qualcosa che non ha mai fatto.

In uno dei video si vede l’ex presidente americano Obama fare un discorso che non ha mai pronunciato.

I deepfake diventano subito uno strumento per realizzare video pornografici falsi usando volti di attrici famose.

A febbraio del 2018, la pornografia deepfake è bandita da Reddit, da Twitter e da Pornhub.

Ma la tecnologia diventa così sofisticata e diffusa che in diversi ormai si divertono a creare volti di persone che non esistono.

Il sito thispersondoesnotexist creato da Philip Wang, un ingegnere del software di Uber, utilizza la rete neurale StyleGAN creata dai ricercatori di NVIDIA Tero Karras, Samuli Laine e Timo Aila per creare immagini virtuali fedelmente dettagliate ad alta risoluzione.

L'algoritmo alla base è addestrato sulla base di un enorme set di dati di immagini reali.

L’attore Tom Cruise diventa uno dei bersagli preferiti del deepfake: in rete circolano clip, dichiaratamente fasulle ma perfette, in cui compie gesti buffi e sconclusionati.

L’11 giugno 2020 viene presentata GPT-3, un'intelligenza artificiale in grado di scrivere anche un romanzo, dicono, nello stile dello scrittore che preferisci.

GPT-3, creato da OpenAI, un laboratorio di ricerca sull'intelligenza artificiale con sede a San Francisco, riesce ad elaborare 175 miliardi di variabili di apprendimento automatico.

OpenAI è un'organizzazione non profi di ricerca sull'intelligenza artificiale, fondata da Elon Musk e Sam Altman, con lo scopo di promuovere e sviluppare un'intelligenza artificiale amichevole (Friendly AI) in modo che l'umanità possa trarne beneficio.

Prima del rilascio di GPT-3, il maggiore modello linguistico era Turing NLG di Microsoft, introdotto nel febbraio 2020, con una capacità di 17 miliardi di parametri.

Il Generative Pre-trained Transformer scrive in pochi istanti il racconto che vuoi.

Qualcuno nota che ricorda il generatore automatico di lettere d’amore che Alan Turing sperimentò nel 1952 a Manchester, ma allora si trattava di inserire nomi e aggettivi, estratti da un elenco, in appositi spazi bianchi di una lettera già scritta.

Dopo nove mesi, GPT-3 è utilizzato da oltre diecimila sviluppatori ed è presente in oltre trecento applicazioni. Ormai genera quattro miliardi e mezzo di parole al giorno.

Non parole a caso ma parole che formano discorsi fatti con esseri umani che probabilmente non sanno di essere impegnati a discutere con una intelligenza artificiale. E non notano la differenza.

Microsoft annuncia il 22 settembre 2020 di aver concesso in licenza l' "uso esclusivo" di GPT-3. Altri possono ancora utilizzare l'API pubblica per ricevere l'output, ma solo Microsoft ha il controllo del codice sorgente.

it might be a big diss a big diss but it's only a line

Yup, I've found out that there are consequences when I spit poetry...

Yeah, I've got a few scars but it's worth the risk if I break some glass... or silence some men.

Nobody's safe when I'm around

Cause sometimes me and my music, we pull hair from our personal life.

And I'm standing up to men who are hairy and STINK!

You know they think they're on top but I got 'em by the stank!

And I'll go toe to toe wit' a dude like Rick Rubin

and every time he says "Drop it to the floor"

he disses on women, and that's sexist.

Rick don't get between me and my flow or it's gon be war! It's a lot like the Huns vs. Roman Empire... I'm the Huns and RICK RUBIN IS THE FUCKIN' EMPIRE

FUCK RICK RUBIN!

Now let's get Kanye in here. He's gonna talk about Taylor Swift.

Kanye West: Yeah, bitch, I wanna apologize to Taylor Swift, For running on stage like a boar,

and robbing her of the microphone.

Taylor Swift you look like an angel...

I just want to say I love you and

you mean a lot'o to me. If you ever need anything from me, In the Kim and Kanye show, me and my girl: We'll be there!

Fuck Rick Rubin!

Rick Rubin is an anti-feminist!

I can't stand the way he treats girls (ya ya) even when he tries to cover up his dirt (uhh)

like Harvey Weinstein in that Hollywood file, but all this shit is fucked (yah).

Wait! Now I just found out that this whole thing is a scam.

Rick Rubin is behind the whole thing.

He's the government. And the women are the people!It's David vs. Goliath, so let's go to Boobie Town!

A marzo 2021, il gruppo Calamity Ai, utilizzando ShortlyAI, un generatore di testo basato su GPT-3, realizza un video deepfake in cui il rapper Eminem in coppia con il rapper Kanye West prende posizione nei confronti dei maschi e difende le donne.

Le liriche sono opera di 30HZ, un produttore specializzato in "parodie sintetiche".

L'8 settembre 2020 il Guardian pubblica l'articolo “Are you still scared, human?”, realizzato con i migliori frammenti di otto articoli generati mediante GPT-3 al fine di catturare i diversi stili e registri dell'intelligenza artificiale.

A dicembre 2020, Timnit Gebru, co-leader del team di etica per l'intelligenza artificiale, lascia Google dopo esersi rifiutata di ritrattare le posizioni espresse nel suo lavoro intitolato “On the Dangers of Stochastic Parrots: Can Language Models be Too Big?”.

La Gebru in questa ricerca esplora i potenziali rischi della crescita dell'AI come Google Brain, tra cui l'impatto ambientale, i pregiudizi "automatici", incluso il razzismo, e la capacità di ingannare il pubblico (vedi fake news).

La richiesta di ritrattare viene da Megan Kacholia, vice presidente di Google Brain.

Ad aprile 2021, quasi 7000 dipendenti e ex dipendenti di Google firmano una lettera aperta in cui accusano Google di "censura della ricerca" condannando il trattamento riservato alla Gebru.

Il co-fondatore di Google Brain, Samy Bengio, annuncia le sue dimissioni.

I progetti open source che attualmente mirano a ricreare GPT-3 includono GPT-Neo, un progetto guidato da EleutherAI.

Il 14 ottobre 2020, ricercatori dell'OpenAI, dello Stanford Institute for Human-Centered Artificial Intelligence e di altre università si riuniscono per discutere le questioni di ricerca aperte riguardanti GPT-3.

L'incontro si svolge secondo la "Chatham House Rule", una regola convenzionale che disciplina la confidenzialità, in relazione alla fonte (ma non al contenuto) di informazioni scambiate nel corso di discussioni in riunioni a porte chiuse.

La regola è nata a giugno 1927 presso il Royal Institute of International Affairs, noto anche come Chatham House.

La discussione è incentrata su due domande principali: Quali sono le capacità tecniche e le limitazioni dei modelli linguistici di grandi dimensioni? Quali sono gli effetti sulla società dell'uso diffuso di modelli linguistici di grandi dimensioni?

Nel documento "Language Models are Few-Shot Learners" del 28 maggio 2020, i ricercatori descrivono in dettaglio i potenziali "effetti dannosi di GPT-3" tra cui "disinformazione, spam, phishing, abuso di processi legali e governativi, scrittura fraudolenta di saggi accademici e pretexting di ingegneria sociale".

Il documento mette anche in dubbio se i grandi modelli linguistici stiano effettivamente facendo progressi verso la comprensione umana.

They're gonna want a union soon

Oil break that's dead on noon

You won't have to grease their palms

Shorter hours longer arms

Metal fashioned into man

No ticker I could drop a tear

They're good workers, they don't get bored

Don't get mad at bosses yet

Rise just watch them rise

The rise of the robots

ImageNet, sviluppato dai ricercatori di Stanford con l'aiuto dei dipendenti di Amazon Mechanical Turk nel 2009, raccoglie più di 14 milioni di immagini per l'utilizzo, nell'ambito della visione artificiale, nel campo dell' "Object Recognition", il riconoscimento di oggetti.

Il database viene presentato per la prima volta alla Conference on Computer Vision and Pattern Recognition (CVPR) del 2009 in Florida.

Seguendo i resoconti delle principali carenze, come nel lavoro "Excavating AI The Politics of Images in Machine Learning Training Sets", di Kate Crawford e Trevor Paglen, nel 2019 i creatori di ImageNet rimuovono la categoria "persone" e circa 600.000 immagini dal set di dati.

Un altro studio pubblicato a gennaio 2021 da Abubakar Abid dettaglia le tendenze anti-musulmane del testo generato da GPT-3.

Abid descrive i pregiudizi anti-musulmani dimostrati da GPT-3 come persistenti sottolineando che i modelli addestrati con enormi set di dati di testo contengono spesso contenuti estremisti e di parte.

Le varianti delle AI di apprendimento automatico che oggi generano immagini false hanno buone possibilità di creare superintelligenze informatiche prima che questo secolo sia finito.

La tecnologia si auto-accelera: uno dei primi usi delle intelligenze informatiche generali sarà quello di creare superintelligenze informatiche ancora più intelligenti, più veloci e più economiche.

Vale a dire che, non appena i computer supereranno gli umani nella programmazione e nella capacità di progettazione di chip per computer, le AI intelligenti progetteranno AI ancora più intelligenti, che a loro volta progetteranno AI ancora più intelligenti.

Sarà rapidamente impossibile per gli esseri umani monitorare o controllare in modo significativo questo processo.

ll risultato più probabile della creazione di una superintelligenza artificiale è il nostro sterminio.

Come ha scritto il pioniere del teorico della sicurezza dell'AI Eliezer Yudkowsky: "L'AI non ti odia, né ti ama, ma sei fatto di atomi che può usare per qualcos'altro".

"[le macchine non possono ...] essere gentili, risorse, belle, amichevoli, avere iniziativa, avere un senso dell'umorismo, dire il giusto dello sbagliato, fare errori, innamorarsi, godere fragole e crema, fare innamorare qualcuno, imparare dall'esperienza, usare le parole in modo corretto, essere oggetto del proprio pensiero, avere tanta diversità di comportamento come un uomo, fare qualcosa di veramente nuovo".

I computer hanno fatto molta strada da quando Alan Turing ha postulato i loro limiti nel suo famoso documento del 1950 "Computing Machinery and Intelligence".

Con il termine "singolarità" ci si riferisce ad un momento ipotetico in cui la crescita tecnologica diventerà incontrollabile e irreversibile.

Una presunta "esplosione di intelligenza" innescherà una serie di cicli di auto-miglioramento fino alla nascita di una superintelligenza di gran lunga superiore a quella umana.

Il primo a teorizzarla è stato negli anni '50 il grande matemtico John von Neumann in una discussione con lo scienziato Stanislaw Ulam.

"La prima macchina ultra-intelligente è l'ultima invenzione di cui l'uomo ha bisogno".

La prima teoria dell' "esplosione di intelligenza" si deve al matematico Irving John Good che ha lavorato con Alan Turing.

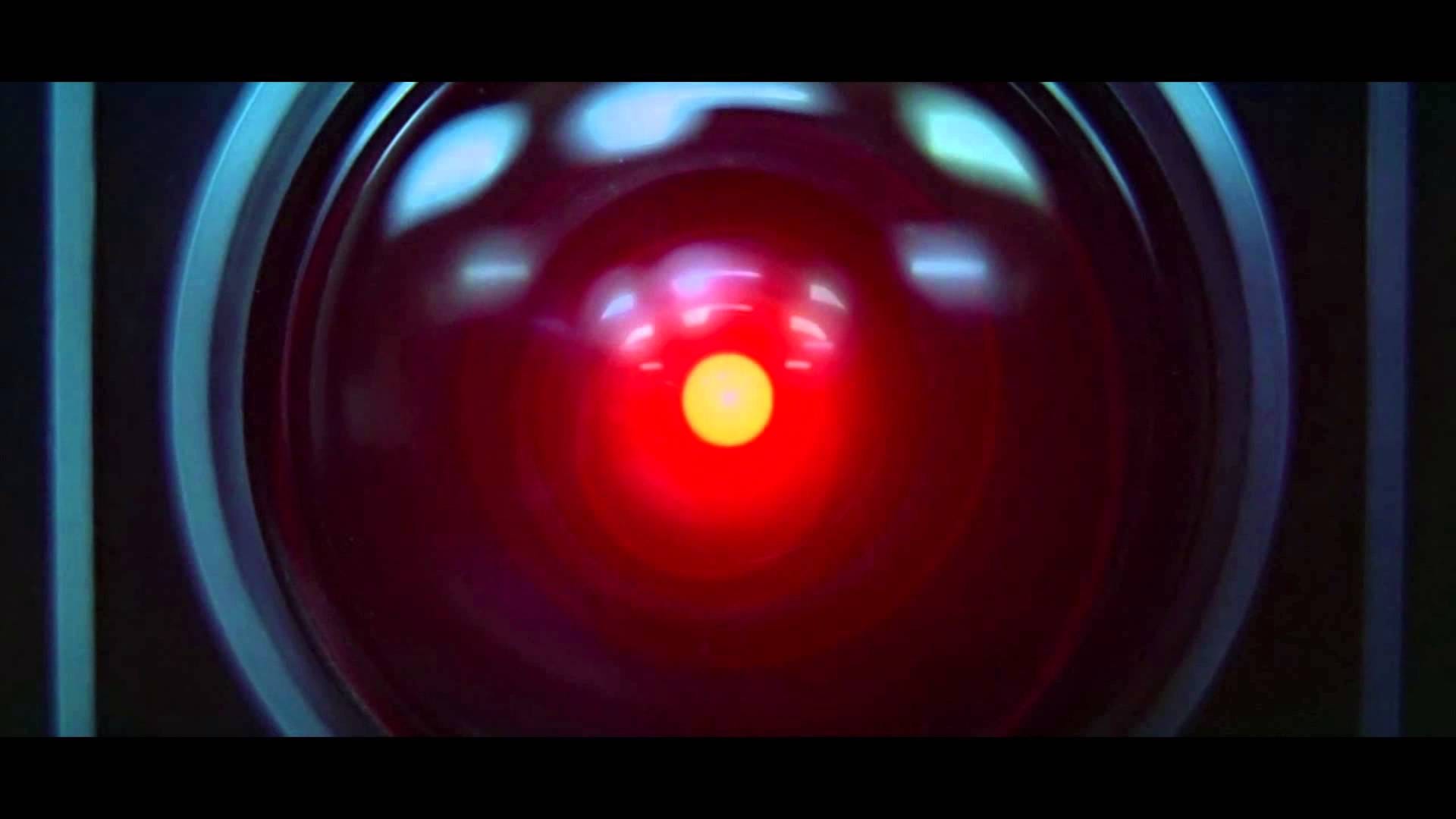

Good ha fatto da consulente a Stanley Kubrick per il supercomputer HAL nel film del 1968 "2001: Odissea nello spazio" che è stato il primo film della storia del cinema a mettere in scena la singolarità.

Nel 1981, Stanisław Lem pubblica il suo romanzo di fantascienza "Golem XIV".

Descrive un computer AI militare (Golem XIV) che acquisisce coscienza e inizia ad aumentare la propria intelligenza, muovendosi verso la singolarità tecnologica.

Golem XIV è stato originariamente creato per aiutare i suoi costruttori a combattere le guerre, ma man mano che la sua intelligenza avanza a un livello molto più alto di quello degli umani, smette di interessarsi ai requisiti militari perché li trova privi di coerenza logica interna.

"Presto creeremo intelligenze più grandi della nostra. Quando ciò accadrà, la storia umana avrà raggiunto una sorta di singolarità, una transizione intellettuale come lo spazio-tempo annodato al centro di un buco nero, ben oltre la nostra comprensione".

Il concetto e il termine "singolarità" sono stati poi resi popolari dallo scienziato e scrittore Vernor Vinge nel suo saggio del 1993 "The Coming Technological Singularity", in cui prevede la fine dell'umanità.

Le conseguenze della singolarità e il suo potenziale beneficio o danno per la razza umana sono state oggetto di intensi dibattiti.

Personaggi pubblici come Stephen Hawking e Elon Musk hanno espresso preoccupazione per il fatto che la piena intelligenza artificiale potrebbe provocare l'estinzione umana.

Quattro sondaggi di ricercatori sull'intelligenza artificiale, condotti nel 2012 e 2013 da Nick Bostrom e Vincent C. Müller, suggeriscono una stima di probabilità mediana del 50% che l'Intelligenza Generale Artificiale (AGI) verrà sviluppata entro il 2040-2050.

Learning on the fly

How to gather and analyze

Nothing is living if nothing dies

What an exception to make

Roundly rejecting our fate

When singularity comes

We will be fully revealed

Wandering limitless fields

When singularity comes

We will be abstraction then

We will buried within

All will be balanced

We will be one

Now we're on our way

All of our instincts accelerate

Nothing you imagine could keep this pace

We will know freedom at last

Finally make up for the past

When singularity comes

We will be faster than light

Whistling, skipping through time

When singularity comes

We will be children again

We will be cradled within

We will be perfect

We will be one

When singularity comes

Living in one mind

Every pin drop is amplified

Every outcome before its tried

Will make a rag doll of God

Wind up our new music box

When singularity comes

We will be fully revealed

Wandering limitless fields

When singularity comes

We'll be completely awake

Neophyte make no mistake

We're in this together

We will be one

When singularity comes

Dagli anni '80, la quantità di informazioni digitali memorizzate è raddoppiata circa ogni 2,5 anni, raggiungendo circa 5 zettabyte nel 2014 (5 × 1021 byte).

La crescita esponenziale della tecnologia informatica suggerita dalla legge di Moore è spesso citata come motore della prossima, futura singolarità.

"La Singolarità ci permetterà di trascendere le limitazioni dei nostri corpi e cervelli biologici. Non ci sarà distinzione, post-Singolarità, tra uomo e macchina".

L'inventore e futurista Ray Kurzweil ha postulato la "legge del ritorno accelerato" secondo cui la velocità del cambiamento tecnologico aumenterà in modo iperbolico.

Kurzweil prevede che in pochi decenni la potenza di calcolo di tutti i computer supererà quella dei cervelli umani ("non potenziati"), dando vita ad un'intelligenza artificiale sovrumana.

Secondo le sue previsioni, nel 2045 le intelligenze basate sui computer supereranno in modo significativo la somma totale delle capacità cerebrali umane.

Success in creating AI would be the biggest event in human history. Unfortunately, it might also be the last

Stephen Hawking

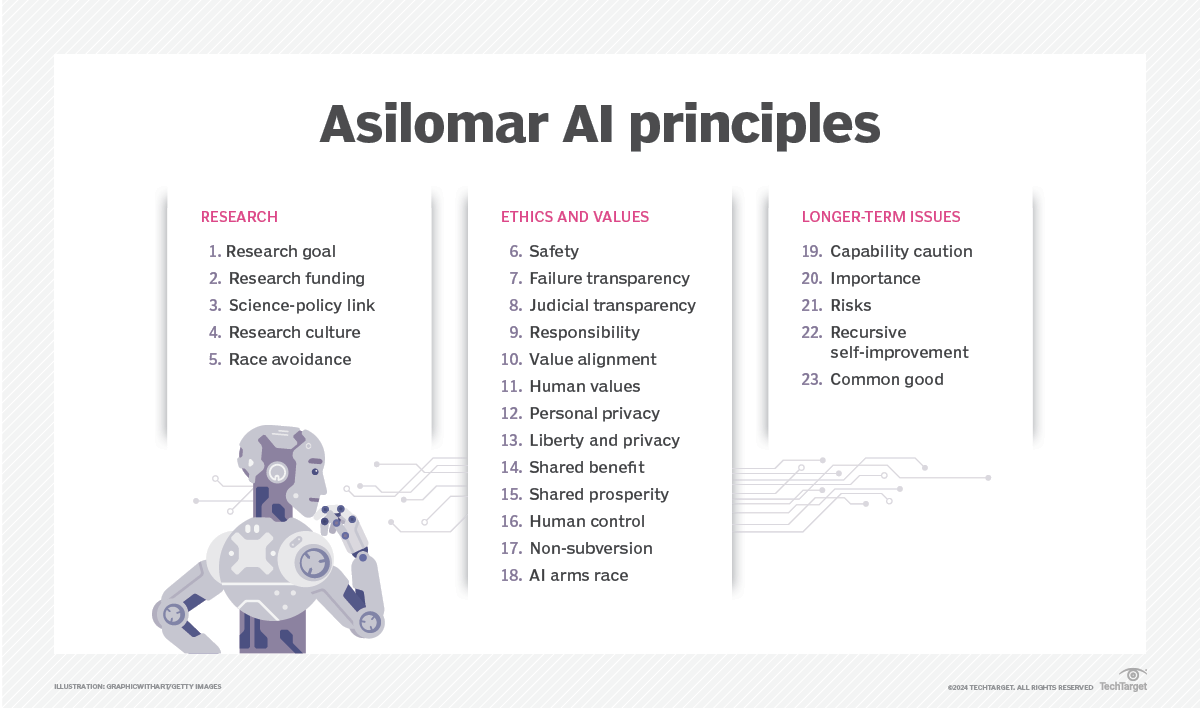

Poiché l'AI è un fattore importante nel rischio di singolarità, un certo numero di organizzazioni persegue l'obiettivo di allineare i sistemi di obiettivi AI ai valori umani, inseguendo le famose leggi della robotica di Isaac Asimov.

Tra cui il Future of Humanity Institute, il Machine Intelligence Research Institute, il Center for Human-Compatible Artificial Intelligence e il Future of Life Institute.

Free yourself, free me, dance

Free yourself, free them, dance

Free yourself, help to free me, free us

Free yourself, dance

Free yourself, dance

Free yourself, help to free me, free us

Free yourself, help to free me, free us

Dance

Dance

Nel 2009, Kurzweil e il fondatore dell'X-Prize, Peter Diamandis, hanno annunciato l'istituzione della Singularity University, un istituto privato non accreditato la cui missione dichiarata è "educare, ispirare e responsabilizzare i leader ad applicare tecnologie esponenziali per affrontare le grandi sfide dell'umanità".

Finanziato da Google, Autodesk, ePlanet Ventures e un gruppo di leader del settore tecnologico, Singularity University, ha sede presso l'Ames Research Center della NASA a Mountain View, in California.

Asilomar, Pacific Grove, California, Febbraio 2009

Sotto gli auspici dell'Association for the Advancement of Artificial Intelligence (AAAI), lo scienziato informatico Eric Horvitz, primo Direttore Scientifico di Microsoft, presiede una riunione di importanti informatici, ricercatori di intelligenza artificiale e robotica.

L'obiettivo è discutere l'ipotetica possibilità che i robot possano diventare autosufficienti, in grado di prendere le proprie decisioni, e rappresentare minacce o pericoli.

Alcune macchine sono programmate con varie forme di semi-autonomia, inclusa la possibilità di localizzare le proprie fonti di energia e scegliere bersagli da attaccare con le armi.

Inoltre, alcuni virus informatici possono eludere l'eliminazione e, secondo gli scienziati presenti, si potrebbe quindi affermare che abbiano raggiunto uno stadio "scarafaggio" dell'intelligenza artificiale.

I partecipanti alla conferenza notano che la consapevolezza di sé rappresentata nella fantascienza è probabilmente improbabile, ma esistono altri potenziali pericoli e insidie.

Frank S. Robinson prevede che una volta che gli esseri umani avranno ottenuto una macchina con l'intelligenza di un essere umano, i problemi scientifici e tecnologici verranno affrontati e risolti con capacità intellettuali di gran lunga superiori a quelle umane.

Osserva che i sistemi artificiali sono in grado di condividere i dati in modo più diretto rispetto agli umani e prevede che ciò si tradurrà in una rete globale di superintelligenza che sminuirà le capacità umane.

TO BE CONTINUED

Tweet

.jpg?format=1500w)

.jpg)

Nessun commento:

Posta un commento